从实时三维渲染软件的发展历程来看,这是一个漫��长的过程。在过去的几年里,随着3D成像的应用急剧增加,带来了令人兴奋的进步。由于无数的技术进步,3D图像可以 实时渲染,只需最少的人工输入,不需要专用的工作站。终端用户也不再需要拥有高性能的游戏电脑,或等待繁琐的下载到他们选择的设备上。

如今,3D渲染的易用性为它在商业、工业和个人环境中创造了

2022-03-19

云渲染?为什么有必要呢?

渲染迪士尼-皮克斯电影的每一帧大约需要24小时。事实上,皮克斯动画工作室(Pixar Animation Studios)最近在一台拥有55000个内核的超级计算机上渲染了超级英雄电影《大英雄6》(Big Hero 6)。

"我们已经说过很多很多次了。我们在测试版渲染器上制作了这��部电影"– 安迪·亨德里克森

2022-03-15

学过设计的同学应该都知道,人们不管是在电脑电视,还是手机VR眼镜里看到的3D物体,其实都是由2D的图像整合形成的,而这个通过计算机视觉把3D模型转换为2D图像的过程就是渲染,这就好比在真实生活中对一个设置好的场景进行拍照或录像。

渲染的方式多种多样,有最基础的多边形渲染,到扫描线渲染,又或是游戏玩家们张口闭口的光线追踪渲染。

2022-03-10

什么是3D渲染?

3D渲染是将想法转换为3D模型并最终转换为2D图像的过程。在过去,技术不像现在那么普遍,可视化作品通常是通过在巨大的蓝图纸上绘图或通过纸板等物理材料建模来完成的。

使用3D渲染的关键因素是以最真实的方式可视化某个产品的想法。在过去,当技术尚未存在时,想法只能通过大部分时间看起来是二维的手工绘图来传达。即使艺术家擅长

2022-03-09

在计算机图形学中,“渲染”是根据场景或模型的描述创建图像。这可能是几毫秒或几个小时的工作。当程序可以在 33 毫秒内渲染给定场景(每秒更新图像超过 30 次)时,通常认为是“实时”的。大多数视频游戏“实时”渲染图形,并根据用户反馈生成,大多数电脑电影不是 实时渲染的。

不过,这种情况正在改变。Unity 游戏引擎能够实时生成复杂场景的高

2022-03-07

多年来,建筑师、设计师和 3D 艺术家一直梦想着实时光线追踪图形。能够实时探索、交互和更改场景可以缩短工作流程,加快完成拍摄的时间,并使客户更容易理解和操作您最复杂的设计。

本文将探讨使实时渲染成为可能的令人难以置信的技术发展,以及开发人员在创建这些独特体验时所面临的挑战。

什么是实时渲染?

允许我们使用计算机创建 3D 图像

2022-03-04

距离 3D实时渲染软件的出现还有��很长的路要走。随着 3D 成像应用的飞速发展,过去几年带来了令人兴奋的进步。由于无数的技术进步,3D 图像可以以最少的人工输入实时渲染,而无需专用工作站。最终用户也不再需要拥有高性能游戏计算机,或等待繁琐的下载到他们选择的设备。

今天 3D 渲染的易用性为其在商业、工业和个人环境中创造了许多新的用例。使

2022-03-02

了解云渲染如何改变 3D 世界以立即生成逼真的渲染。自 1996 年问世以来,云计算已发展成为一个强大的资源,我们几乎可以从任何设备存储、处理和访问数据。它是一个远程服务器网络,可用于卸载渲染任务、流式传输视频游戏、电影和电视,以及通过稳定的互联网连接处理大型数据集。

那么云计算如何融入3D 世界呢?3DCAT是如何改变领先行业日常所依

2022-03-01

云技术正在改变另一个领域:实时渲染。与在设备 GPU 上运行计算机生成图像的当前标准相比,云流(或像素流)描述了一种技术,该技术为每个用户提供强大的远程机器来在线计算逼真的高质量图像。最终图像实时流式传输到用户的硬件,用户输入被发送回云中的应用程序。

但是今天这项技术有多先进?能否在浏览器中用 WebGL 代替实时渲染?让我们在接下来的

2022-02-28

不少用户不能理解,为什么要选用实时云渲染,而不用本地的电脑进行渲染显示?本文将通过各个方面来对比两种模式的优劣支持,帮助您更全面了解实时云渲染和本地渲染。

一、便携性对比

由于GPU对机箱空间有要求,本地渲染往往需要携带沉重的服务器工作站前往场地提前拉线和部署,耗时耗力。

3DCAT实时云渲染只需要轻薄的手持终端或笔记本设备

2021-07-09

热门标签

云技术云软件unity游戏动画云游戏即时渲染实时交互实时光线追踪云加速实时渲染艺术家实时游戏AR/VR渲染CloudXR虚拟制作元宇宙虚拟数字人云工作站元宇宙解决方案虚拟现实汽车虚拟仿真vr虚拟现实云渲染实时云渲染元宇宙云化XRCloud VRue4UE5边缘计算平台云交互云仿真云展厅虚拟仿真云流送技术云流送像素流UE虚幻引擎3D数字孪生平台数字孪生虚拟仿真软件三维虚拟仿真3D场景制作GPU渲染像素流送的成本实时渲染实时3D3D可视化C4D沉浸式云应用

热门资讯

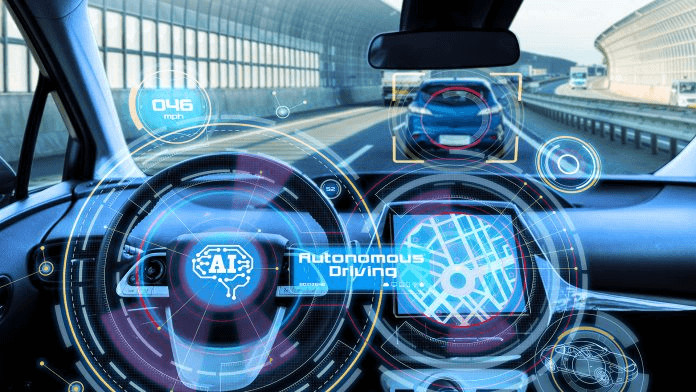

汽车ai辅助设计-AI技术在汽车上的应用

2024-11-08

AIGC+汽车:为行业带来创新型解决方案!

2024-11-01

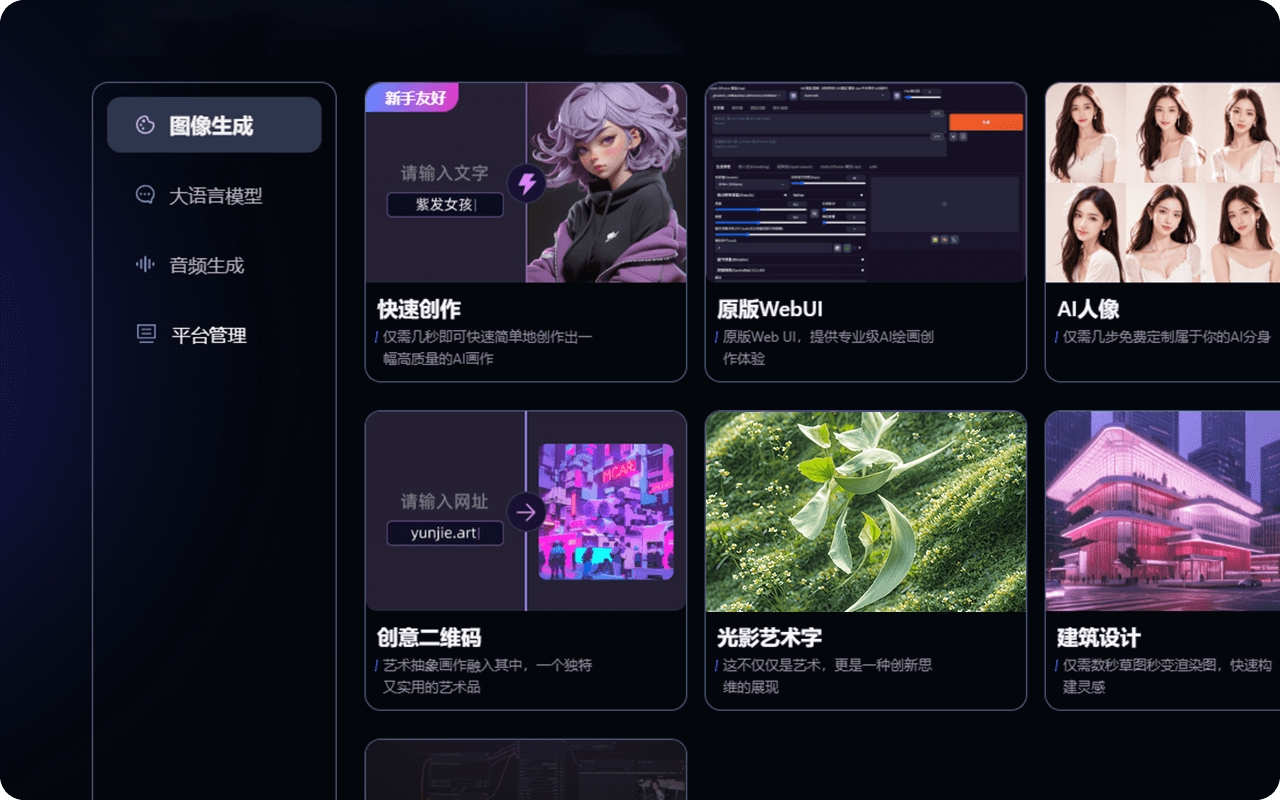

AIGC可以生成哪些内容?在内容创作、实训中有何突破?

2024-11-01

人工智能技术在汽车行业的应用_汽车AI应用

2024-10-07

AIGC平台有哪些?一站式AIGC创作平台推荐!

2024-09-27

汽车AIGC:数字化转型中的关键驱动力!

2024-09-11

最新资讯

2024-11-18

2024-11-15

2024-11-14

2024-11-13

2024-11-12

2024-11-11

2024-11-08

2024-11-07