英伟达(NVIDIA) 最近分享了它的SIGGRAPH 2020论文,该论文探索了如何 实时渲染数百万个区域动态灯光的照明和阴影。

多光线追踪(ReSTIR)

以前,游戏工作室使用烘焙解决方案,并添加了一些Dynamic Emitters。然后,RTX游戏允许开发者使用具有物理上正确阴影的动态区域灯光,但会限制在一定数量的灯光。R

2020-06-02

过去,NVIDIA一直在谈论CPU和GPU,而今年GTC演讲的重点是基于云/服务器的计算与DPU(深度学习处理单元)的结合。以前,NVIDIA的叙述主要是使用AI进行光线追踪,但这些结果更多地反映了降噪算法。今年,黄教主表现出令人难以置信的高画质效果,其中ML在推断更高分辨率的光线追踪渲染器方面提供了惊人的结果。该过程将光线跟踪与ML耦合

2020-05-27

NVIDIA首席执行官黄仁勋(Jensen Huang)在2020年GTC主题演讲中宣布了该公司的一系列重大新技术进步,其中三项与媒体和娱乐(M&E)空间非常相关。

1. 受益于深度学习超级采样(DLSS)2.0的NVIDIA光线追踪。

2. 扩展的Omniverse。

3. 作为Jarvis对话式AI框架的一部分,出色的角色动画讲话。

2020-05-26

热门标签

云技术云软件unity游戏动画云游戏即时渲染实时交互实时光线追踪云加速实时渲染艺术家实时游戏AR/VR渲染CloudXR虚拟制作元宇宙虚拟数字人云工作站元宇宙解决方案虚拟现实汽车虚拟仿真vr虚拟现实云渲染实时云渲染元宇宙云化XRCloud VRue4UE5边缘计算平台云交互云仿真云展厅虚拟仿真云流送技术云流送像素流UE虚幻引擎3D数字孪生平台数字孪生虚拟仿真软件三维虚拟仿真3D场景制作GPU渲染像素流送的成本实时渲染实时3D3D可视化C4D沉浸式云应用

热门资讯

汽车ai辅助设计-AI技术在汽车上的应用

2024-11-08

AIGC+汽车:为行业带来创新型解决方案!

2024-11-01

AIGC可以生成哪些内容?在内容创作、实训中有何突破?

2024-11-01

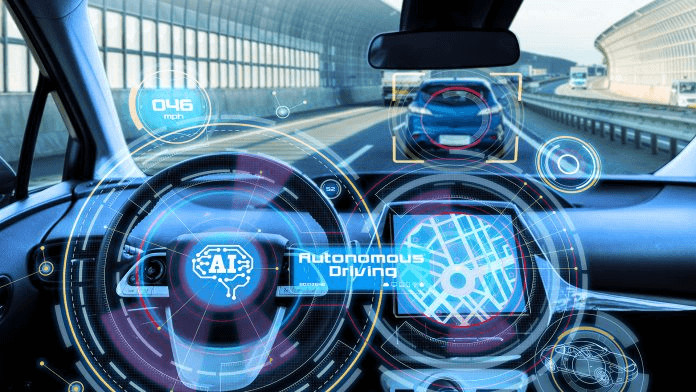

人工智能技术在汽车行业的应用_汽车AI应用

2024-10-07

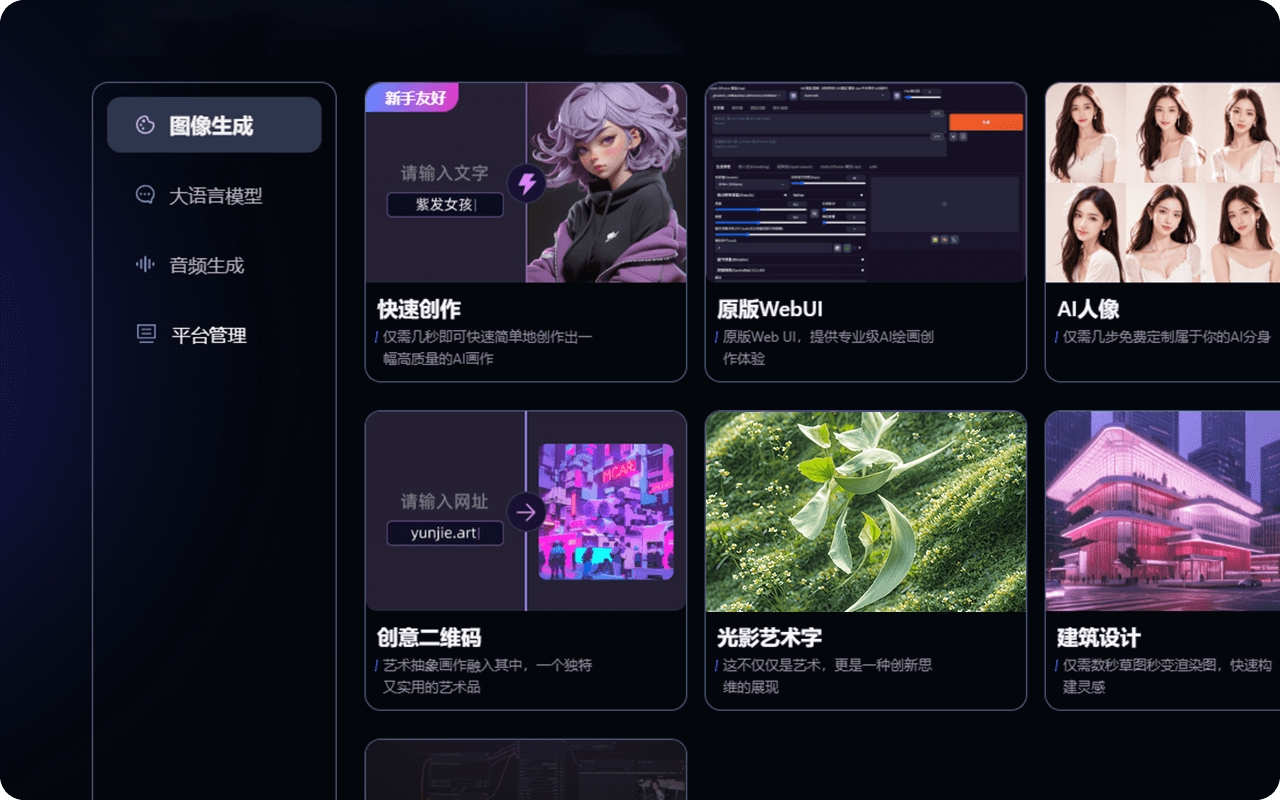

AIGC平台有哪些?一站式AIGC创作平台推荐!

2024-09-27

汽车AIGC:数字化转型中的关键驱动力!

2024-09-11

最新资讯

2024-11-18

2024-11-15

2024-11-14

2024-11-13

2024-11-12

2024-11-11

2024-11-08

2024-11-07