在现代建筑设计界中,建筑师需要视觉手段与客户交流有关设计计划�的细节。这些视觉手段是对未建项目的最好描述。

如今,现代建筑师使用可视化, 实时渲染和 虚拟现实与潜在客户和潜在客户交流设计计划。提供可视化是生成买入的最佳方法。在可视化行业竞争如此激烈且人满为患的情况下,虚拟现实,渲染和可视化几乎已成为商品。

清楚地了解目标

在开始任

2020-05-03

3D可视化或3D渲染在当今变得越来越流行。建筑公司,室内设计师和房地产公司已经意识到,向客户展示其项目的逼真图像可以为公司带来很多好处。

3D可视化或3D渲染在当今变得越来越流行。建筑公司,室内设计师和房地产公司已经意识到,向客户展示其项目的逼真图像可以为桌子带来很多好处。

使用3D渲染,您可以精确地看到所需项目的外观。 3D可视

2020-04-30

如今,借助 实时3D可视化工具的强大功能,品牌商可以帮助客户做出明智的决策,从而提高客户满意度并改善用户体验。

我们都知道买东西然后过后悔是多么糟糕,尤其是当它非常昂贵时。买方的后悔是所有人都经历过至少一次的事情。对于客户而言,这是一场噩梦,但对于全球每个品牌而言,买家的后悔是最糟糕的噩梦。

对于建筑等微妙的行业来说尤其如此,即使是

2020-04-27

在过去的几年中,AR一直在发展,并且已经在众多不同的行业中被使用。但是,实际上与体系结构内的实现有多远?

AR技术只是在上升。随着高级计算机技术能力的不断提高,它已在众多行业中站稳脚跟,而架构艺术也不例外。

尽管VR和AR在表面上听起来很相似但相差甚远。当虚拟现实技术在为尚未发明,想到或制造的事物绘制图片时,AR功能可以增强我们已经

2020-04-22

渲染软件是许多专业人士使用的功能强大的工具。但是,这些工具也有其局限性,将来必将发生变化。

目前,有许多渲染器可供设计师和建筑师选择。本质上,所有这些软件解决方案都是出于相同目的而设计的。但他们都有各自的特点,这不是一个简单的话题,因为关于渲染软件有很多事情要知道。

最新的工具经常更新,并且每年都会推出新的硬件选项,因此它们必须保持

2020-04-17

当前的技术和可用软件已经将渲染提升到一个更大的领域,该领域的人包括CG艺术家,建筑师,工程师,开发人员等。 实时渲染突破了主流渲染和可视化技术存在的局限。

主流建筑渲染和可视化得到了发展,它的名称是实时渲染,依赖于渲染和可视化技术,实时渲染在行业中的地位和可用性正在不断提高。

在本文中,你将了解有关实时渲染的所有知识,以及为什么它在我们思

2020-04-10

推荐阅读: 什么是实时渲染

实时渲染使过程更好

虽然用 实时渲染向客户进行演示会面临许多新的挑战,但我认为实时渲染是优化设计过程的重要途径,实时渲染才能真正体现设计作品更好的全貌。

设计过程全都围绕着一个不断循环的试验和反馈,试验和反馈,试验和反馈-直到你无法按时完成任务或用光为止。优秀的建筑师和设计师会以最高的重视度来拥护他

2020-04-09

如果你刚开始在Unity中进行3D开发,你可能还不太清楚什么是渲染。对于偶尔使用3D图形的人或刚开始使用3D进行生产制作的人�,可能会发现渲染并不像3D图形的其他方面那么容易。

好在有很多关于在Unity中设置渲染的文档,帮助你更好的实现项目。

什么是3D实时渲染,它是如何工作的?

3D渲染是根据计算机上存储的三维数据生成图像的过程。与

2020-04-08

By:Frank Manley

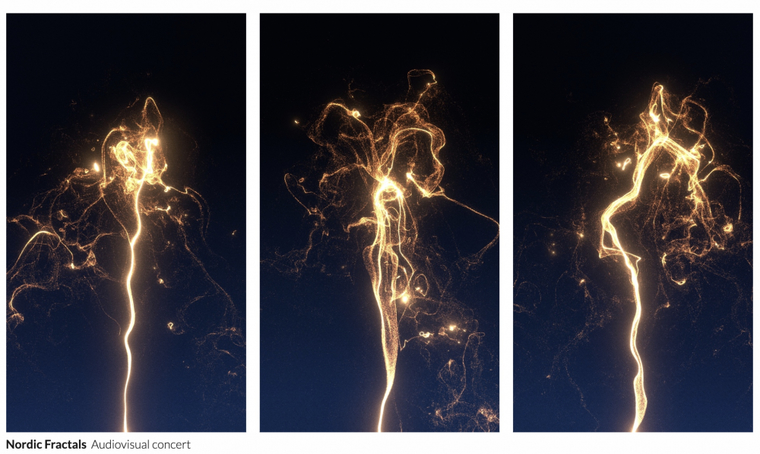

您是否体验过视觉音乐或惊艳的虚拟现实表演?在这篇文章中,我们与一位创新的丹麦创作者进行了幕后讨论,他通过在剧院和展览空间中投影Unity带来的体验来挑战观众的感知。

交互设计师兼媒体艺术家卡尔·埃米尔·卡尔森(Carl Emil Carlsen)“我对制作融合虚拟和物理现象的交互式视听幻觉感兴趣。我

2020-04-02

Hao Li和Pinscreen的团队最近展示了 实时交互式的人脸替换功能,实现了当人走到屏幕前,就能在实时的“Deepfake”中换脸。该装置展示于瑞士的世界经济论坛(WEF),世界经济论坛在瑞士阿尔卑斯山小镇达沃斯举行。它成立于1971年,是一个非政府组织(NGO)。WEF的使命是“致力于通过商业,政治,学术和其他领域的社会领袖的共同

2020-03-03

热门标签

云技术云软件unity游戏动画云游戏即时渲染实时交互实时光线追踪云加速实时渲染艺术家实时游戏AR/VR渲染CloudXR虚拟制作元宇宙虚拟数字人云工作站元宇宙解决方案虚拟现实汽车虚拟仿真vr虚拟现实云渲染实时云渲染元宇宙云化XRCloud VRue4UE5边缘计算平台云交互云仿真云展厅虚拟仿真云流送技术云流送像素流UE虚幻引擎3D数字孪生平台数字孪生虚拟仿真软件三维虚拟仿真3D场景制作GPU渲染像素流送的成本实时渲染实时3D3D可视化C4D沉浸式云应用

热门资讯

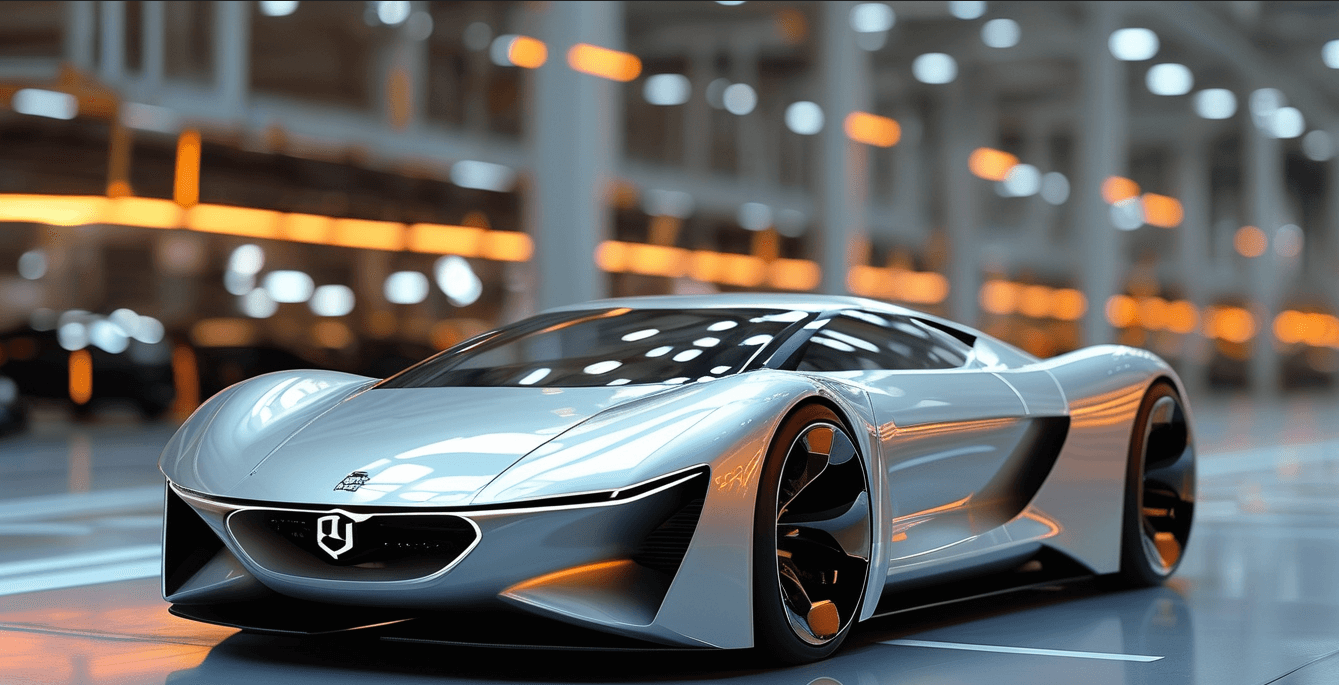

汽车ai辅助设计-AI技术在汽车上的应用

2024-11-08

AIGC+汽车:为行业带来创新型解决方案!

2024-11-01

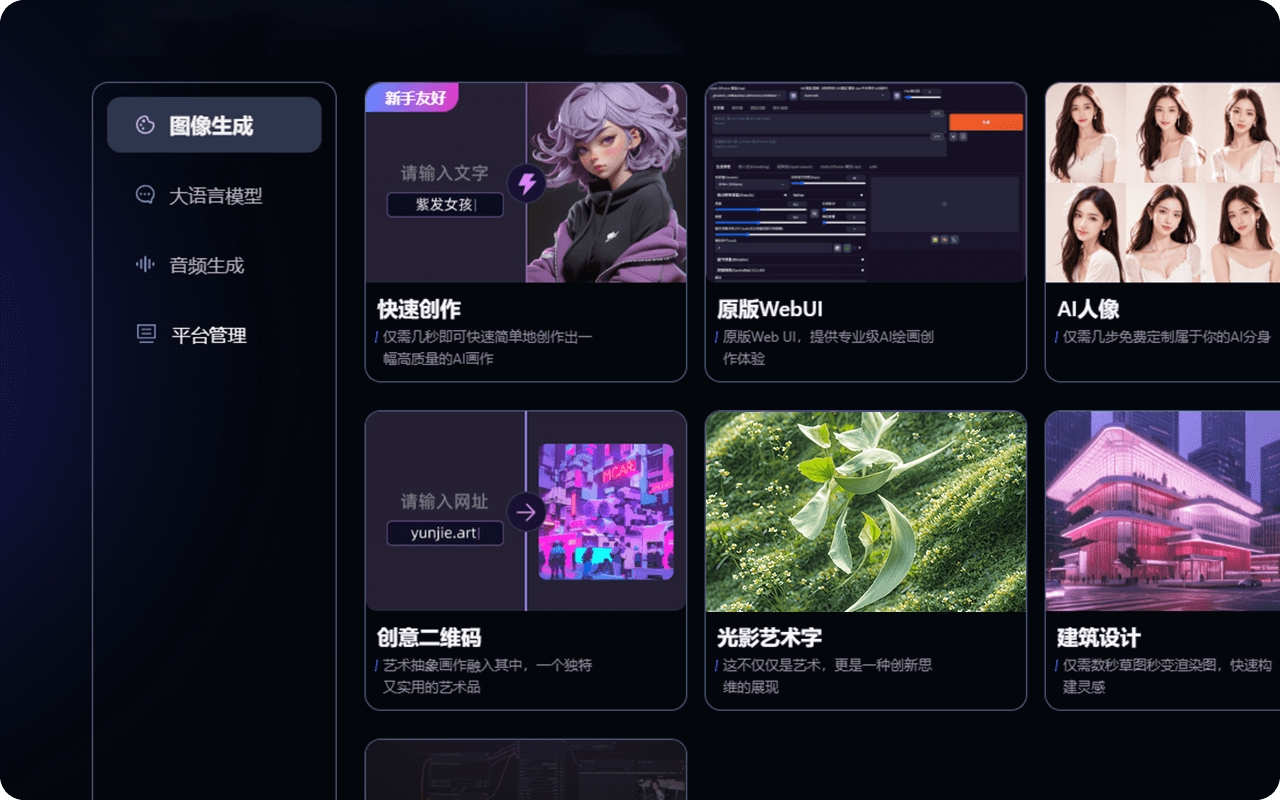

AIGC可以生成哪些内容?在内容创作、实训中有何突破?

2024-11-01

人工智能技术在汽车行业的应用_汽车AI应用

2024-10-07

AIGC平台有哪些?一站式AIGC创作平台推荐!

2024-09-27

汽车AIGC:数字化转型中的关键驱动力!

2024-09-11

最新资讯

2024-11-18

2024-11-15

2024-11-14

2024-11-13

2024-11-12

2024-11-11

2024-11-08

2024-11-07