诸如实时3D渲染之类的技术可以带来的令人赞叹的因素无疑受到了各个行业企业的关注。但是,许多专业人员可能很难理解该技术是否适合他们。以下是 关于实时3D渲染的几个最常见问题的一些答案,这些答案可能会消除一些常见问题的困惑:

如何确保所创建的内容能够带来最佳的实时体验?

首先要重点关注优化和工作流程。诸如Unity和Unreal E

2020-11-16

当Epic game创始人兼CEOTim Sweeney在1995年的时候为unreal engine写下第一行代码的时候,他永远都想不到现在的发展与成就。

22年后,虚幻已经成为了世界上最受欢迎的游戏引擎,支持世界上大部分流行的游戏。同时,也参与制作了各种大型的TV电视节目以及大电影,还有建筑,��医疗健康,国防,航空和能源服务组织等方面

2020-10-10

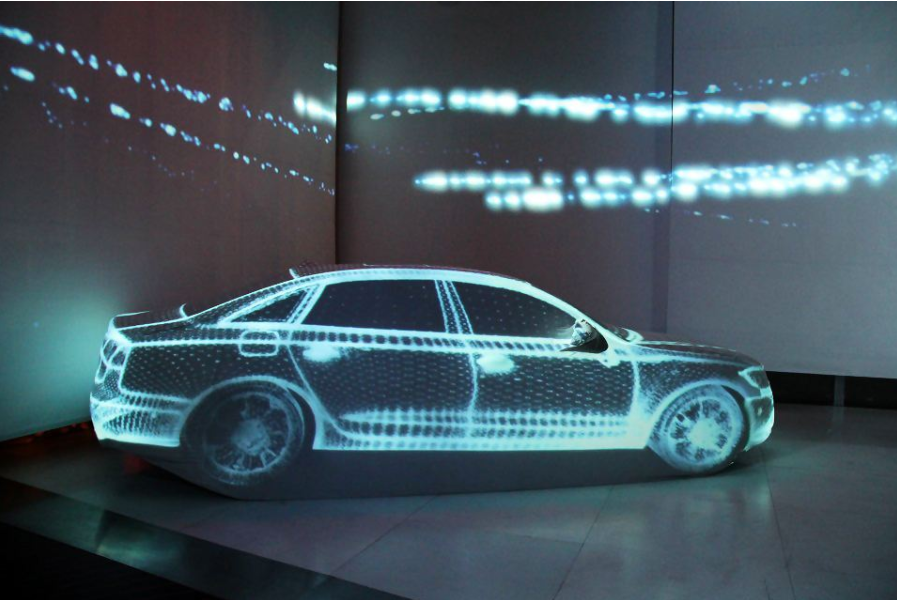

随着5G的普及, 像素流送相关技术广泛应用于生活中。例如汽车展示、建筑漫游、工业仿真、游戏试玩、手办模型展示、艺术展览、医疗实训、智慧党建、智慧园区……那么 像素流送到底有哪些优势?

像素流送的优点

1.用户体验一致

即使是手机这种轻量化的终端也能体验到服务器级别的高端显卡带来的震撼效果,尤其是一些复杂的场景,以往在手机上是无法运行的

2020-10-05

5G的到来不仅仅是网络的提升,它还解锁了人与人之间新的交互方式,就比如逐渐渗透到人们生活的仿真类VR、AR相关应用。这些应用的内容,通过云端资源进行渲染计算,然后搭载着 内容流送(Content Streaming)/像素流送(Pixel Streaming)这项技术通过网络,推送到各种终端上。

像 3DCAT实时渲染云平台就是通过 像

2020-09-30

基本上,在 实时渲染中,计算机需要在运行时生成所有的3D模型、贴图等等,并以尽可能快的速度(每秒30帧以上)显示给用户。用户可以通过鼠标、游戏手柄、平面电脑等设备的3D场景进行交互,你可以在设备上得到相应的实时图形,此时,你使用的应用程序视图的画面则是通过实时渲染而计算出来的画面。(PS:可以理解为你在移动端/PC端玩的游戏,也都是实

2020-09-04

Jasmin Habezai-Fekri介绍她最新的卡通风格 实时游戏场景作品Sunny Market Entrance,使用软件包括Blender,Substance Suite和ZBrush。

灵感

每次开始一个新项目,我会尝试我以前的作品中没有探讨过的环境或视觉主题。当我偶然发现Hyunsu Cha的市场入口时

2020-06-10

NVIDIA首席执行官黄仁勋(Jensen Huang)在2020年GTC主题演讲中宣布了该公司的一系列重大新技术进步,其中三项与媒体和娱乐(M&E)空间非常相关。

1. 受益于深度学习超级采样(DLSS)2.0的NVIDIA光线追踪。

2. 扩展的Omniverse。

3. 作为Jarvis对话式AI框架的一部分,出色的角色动画讲话。

2020-05-26

如今,借助 实时3D可视化工具的强大功能,品牌商可以帮助客户做出明智的决策,从而提高客户满意度并改善用户体验。

我们都知道买东西然后过后悔是多么糟糕,尤其是当它非常昂贵时。买方的后悔是所有人都经历过至少一次的事情。对于客户而言,这是一场噩梦,但对于全球每个品牌而言,买家的后悔是最糟糕的噩梦。

对于建筑等微妙的行业来说尤其如此,即使�是

2020-04-27

渲染软件是许多专业人士使用的功能强大的工具。但是,这些工具也有其局限性,将来必将发生变化。

目前,有许多渲染器可供设计师和建筑师选择。本质上,所有这些软件解决方案都是出于相同目的而设计的。但他们都有各自的特点,这不是一个简单的话题,因为关于渲染软件有很多事情要知道。

最新的工具经常更新,并且每年都会推出新的硬件选项,因此它们必须保持

2020-04-17

推荐阅读: 为什么Unity作为3D渲染解决方案如此受欢迎?-part1

能创建逼真的图形和场景

无论你是使用Unity开发2D还是3D游戏,你都可以放心,这些图形将令人惊讶。老实说,今天我们都知道,许多游戏玩家对图形的重视程度超过其他任何事物。因此,如果你想出售自己的游戏,则需要确保其外观完美。

这就是Unity允许你执行的

2020-04-14

热门标签

unity游戏动画云游戏即时渲染实时交互实时光线追踪云加速实时渲染艺术家实时游戏AR/VR渲染CloudXR虚拟制作元宇宙虚拟数字人云工作站元宇宙解决方案虚拟现实汽车虚拟仿真vr虚拟现实云渲染实时云渲染元宇宙云化XRCloud VRue4UE5边缘计算平台云交互云仿真云展厅虚拟仿真云流送技术云流送像素流UE虚幻引擎3D数字孪生平台数字孪生虚拟仿真软件三维虚拟仿真3D场景制作GPU渲染像素流送的成本实时渲染实时3D3D可视化C4D云技术沉浸式云软件云应用

热门资讯

2024年值得关注的五大生成式AI+XR趋势

2024-07-22

简述边缘计算的定义_边缘计算产品是什么意思?

2024-07-04

CloudXR助力汽车虚拟仿真可视化

2024-06-25

CloudXR:为XR领域应用开启无限机会!

2024-06-19

目前实时云渲染技术特点下的用户体验如何?

2024-06-14

AIGC实训教学的好处与巨大潜力

2024-06-11

最新资讯

2024-07-26

2024-07-25

2024-07-25

2024-07-24

2024-07-24

2024-07-23

2024-07-22

2024-07-22