GPU渲染彻底改变了实时游戏、3D建模与动画等多个领域。在图形处理单元(GPU)进入市场之��前,生成逼真的高分辨率图像依赖于中央处理器(CPU),而中央处理器只有几个核心来处理图像。然而,GPU则是使用数千个并行工作的核心来提高处理速度。

图源网络

虽然这项进步已经改变了多个行业,但关于GPU的工作原理以及它们为何对3D/XR应用至关重要

2024-10-02

创建3D模型往往需要较强的制作能力,渲染3D模型的时间也在几小时到几天不等,为了避免过长的等待时间、优化渲染过程,我们可以使用云资源,比如借助云3D渲染更快地渲染复杂模型,不用自己准备昂贵IT硬件。本篇内容将简述云渲染是什么、云渲染类别和工作方式。

1、什么是云渲染?云渲染类别

云渲染的核心就是使用云端服务器执行渲染高质量图像或动画所需

2024-07-24

当涉及3D可视化、机器学习和人工智能等繁重的计算任务时,拥有可靠的GPU计算资源就显得至关重要。过去,企业经常面临培训时间长、计算任务成本高昂、设备维护难的挑战,从而造成生产力下降和数据存储等限制。

到如今,最新的GPU技术通过提供增强的并行处理能力彻底改变了这一格局,大大缩短了AI模型的训练时间,这种提升就是云GPU解决方案,云端GPU

2024-06-12

什么是GPU?

多年来,深度学习、图形渲染和AI计算等领域的技术得到了巨大改进,而对应用程序的速度、准确性和分辨率的要求也显著提高。例如,现代游戏需要更大的存储容量来容纳额外的视觉元素以及更高的处理速度,来支持精细的视觉效果、后台操作,以此获得更好的游戏体验。简单理解就是我们需要更高的计算资源,来运行支持现代计算密集型应用程序所需的大量操

2024-05-29

在数字化飞速发展的今天,计算能力成了推动科技进步和产业升级的重要动力。而在这个浪潮中,GPU服务器靠着其强大的并行处理能力,渐渐成了众多企业和研究机构离不开的算力基石。这篇文章会深入探讨GPU服务器的重要性、发展趋势,还有GPU云服务器租用的好处和选择策略。

GPU服务器的重要性与趋势

GPU重要是因为它独特的并行处理能力。和传统的CP

2024-05-20

什么是云GPU?

首先,GPU是可以拥有数百甚至数千个、专为多线程和并行处理工作负载而设计的较小核心,而云GPU是指基于云计算作为服务提供的某种GPU使用方式,和传统的云服务有点相似,云GPU让我们可以按需使用高性能计算资源,随时随地高效使用,无需前期投资硬件等。

图源网络

云GPU有哪些功能/应用领域?

云GPU主要会被用于处理需要高

2024-05-07

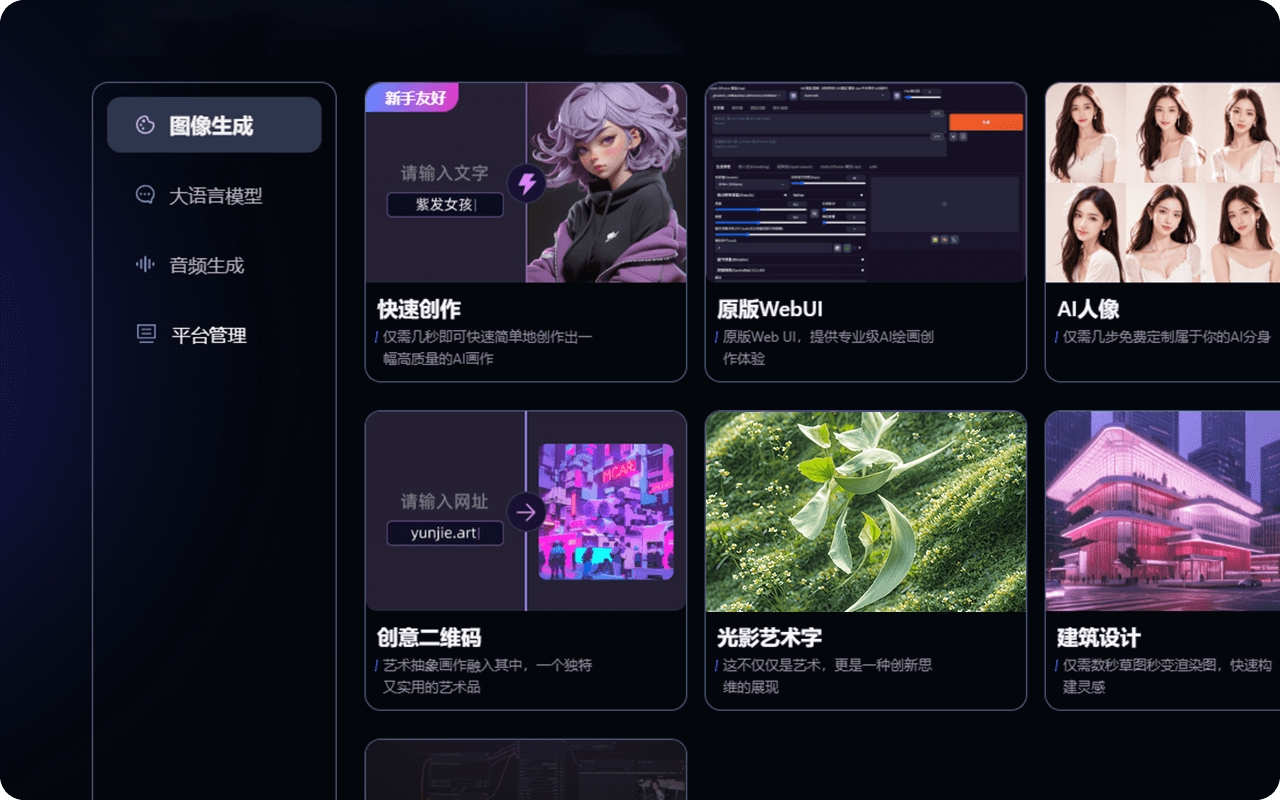

什么是云GPU平台?

云GPU平台是GPU服务器租赁商提供的一项服务,是一种新的云计算方法,用户可以远程访问和利用云端GPU资源,也不用�购买或者在本地计算机中安装物理GPU,直接可以使用高效云GPU平台上托管的云GPU的强大功能。这些平台(例如3DCAT实时云渲染)利用高性能GPU服务器资源,使用户可以通过云端访问它们,也更有助于完成项目

2024-04-23

要建设先进的 AI 系统、例如大语言模型和深度学习网络,就需要巨大的服务器处理能力,这时会由 GPU 服务器提供必要的计算能力来推动 AI 等应用的进步。

GPU服务器使AI开发变得更加容易,不仅减少了训练时间,也让我们能够创建以前费时费力才能完成的人工智能模型。本文,3DCAT实时渲染小编将探讨您需要了解的有关 AI 任务的 GPU 服

2024-04-17

但是 GPU 为何如此适合处理 AI 任务呢?答案在于它和 CPU 之间的根本区别。虽然 CPU 和 GPU 都是处理器,但二者的架构还是有很大不同,CPU擅长顺序处理,运行操作系统和高效处理单个任务的时候很适用,但在处理训练人工智能模型所需的海量数据集和复杂计算时,CPU的顺序方法就不太适用了,这就是为什么更推荐 GPU 用于 AI 开

2024-04-16

高性能计算和数据处理仍然是采用的主要驱动因素。如今,云计算行业的企业和个人始终面临一个关键问题:应该购买图形处理单元(GPU)还是选择云端GPU服务器租赁?而这个问题没有简单的一刀切答案,这两种选择都非常容易获得,并且具有独特的优势。

图源网络

实际上决策取决于各种因素,包括具体的计算需求、预算考虑以及相关个人或团队的长期战略目标。所以

2024-04-10

热门标签

云技术云软件unity游戏动画云游戏即时渲染实时交互实时光线追踪云加速实时渲染艺术家实时游戏AR/VR渲染CloudXR虚拟制作元宇宙虚拟数字人云工作站元宇宙解决方案虚拟现实汽车虚拟仿真vr虚拟现实云渲染实时云渲染元宇宙云化XRCloud VRue4UE5边缘计算平台云交互云仿真云展厅虚拟仿真云流送技术云流送像素流UE虚幻引擎3D数字孪生平台数字孪生虚拟仿真软件三维虚拟仿真3D场景制作GPU渲染像素流送的成本实时渲染实时3D3D可视化C4D沉浸式云应用

热门资讯

汽车ai辅助设计-AI技术在汽车上的应用

2024-11-08

AIGC+汽车��:为行业带来创新型解决方案!

2024-11-01

AIGC可以生成哪些内容?在内容创作、实训中有何突破?

2024-11-01

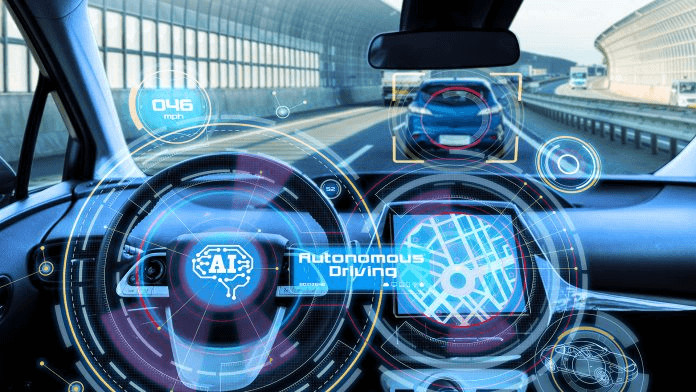

人工智能技术在汽车行业的应用_汽车AI应用

2024-10-07

AIGC平台有哪些?一站式AIGC创作平台推荐!

2024-09-27

汽车AIGC:数字化转型中的关键驱动力!

2024-09-11

最新资讯

2024-11-18

2024-11-15

2024-11-14

2024-11-13

2024-11-12

2024-11-11

2024-11-08

2024-11-07